Fill Factor e Full Well Capacity

Analizzando in dettaglio le caratteristiche di un sensore a semiconduttore, possiamo notare come la capacità di raccogliere i “fotoni cosmici” dipende strettamente dal tipo di architettura utilizzata. Infatti a differenza dei sensori CCD dove l’area sensibile coincide con il pixel stesso (ad esclusione degli Interline Transfer), nei sensori CMOS parte è occupata dall’elettronica. I pixel dei sensori CMOS risulteranno pertanto meno sensibili alla luce. Ma quanto?

Per quantificare questo effetto è stato introdotto il concetto di pixel fill factor (FF) definito come il rapporto percentuale tra l’area fotosensibile e quella del pixel. Il FF sarà quindi tanto maggiore quanto più estesa sarà la superficie attiva del sensore. Per i CCD valori tipici di pixel fill factor si aggirano intorno al 90% scendendo al 30% nel caso dei CMOS.

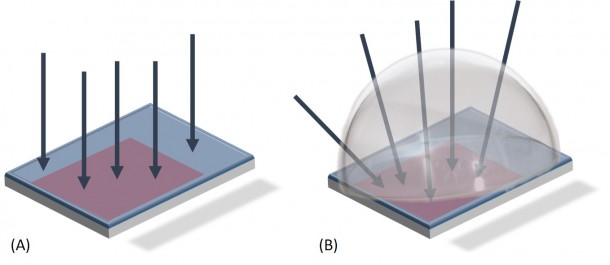

Il basso pixel fill factor dei sensori CMOS è stato originariamente un limite invalicabile. Fortunatamente, grazie al progresso tecnologico in ambito opto-meccanico, si è riusciti a produrre lenti convergenti del diametro di alcune decine di micrometri (!) capaci di convogliare i raggi luminosi incidenti nelle regioni sensibili del pixel. Queste lenti prendono il nome di microlenti.

Grazie alle microlenti è stato pertanto possibile aumentare quello che definiremmo “l’effettivo pixel fill factor” fino a valori prossimi al 100%. Non fatevi quindi ingannare dalle apparenze e cercate informazioni sul pixel fill factor reale e non quello corretto dalle microlenti. Oltre ad aumentare l’FF, le microlenti hanno l’effetto di ridurre l’alone generato dalla luce diffusa dalle parti non fotosensibili del pixel. Questo effetto è importante soprattutto nel caso di sorgenti di luce intensa. Recentemente, l’azienda CentralDS fornisce un servizio di debayerizzazione delle reflex digitali al fine di ottenere camere monocromatiche. Questo avviene rimuovendo sia i filtri colorati della matrice di Bayer che le microlenti poste di fronte a ciascun pixel. Così facendo si ha una riduzione del pixel fill factor effettivo (dal 90% al 30% circa) compensato però dall’aumento di trasmittanza dovuto alla rimozione dei filtri colorati (dal 40% al 100% circa). Ovviamente permane il problema dell’alone per le sorgenti luminose, fortunatamente marginale in ambito astrofotografico.

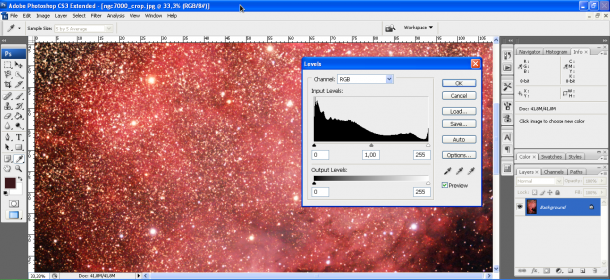

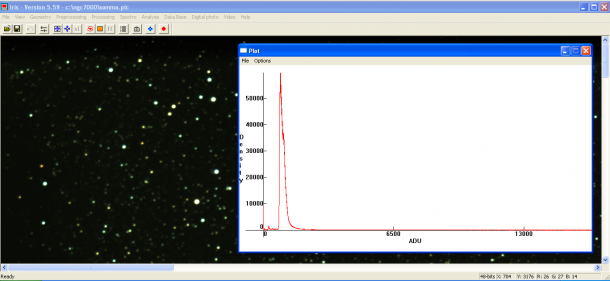

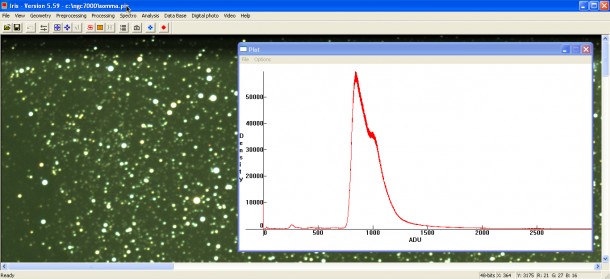

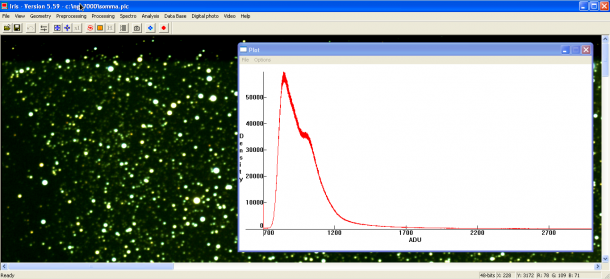

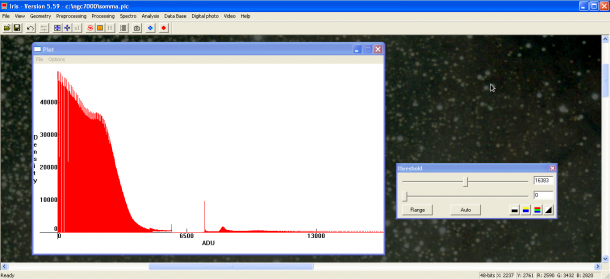

Un’altra caratteristica dei pixel che costituiscono il sensore digitale è la full well capacity (FWC). Questa grandezza fisica è definita come la quantità massima di elettroni che possono essere accumulati all’interno di un elemento fotosensibile. Tale caratteristica dipende dal potere capacitivo del fotoelemento (capacity), immaginato come un pozzo dove vengono raccolti i fotoelettroni (well). La FWC, che varia generalmente tra le decine e le centinaia di migliaia di elettroni, fissa la quantità massima di fotoni che può raggiungere un fotoelemento prima che questo raggiunga la saturazione. Di conseguenza verrà fissata anche la dinamica della camera stessa. Quest’ultima, definita come il numero di sfumature di grigio tra il bianco ed il nero è importante in astrofotografia dove spesso abbiamo forti contrasti tra soggetti luminosi (stelle) e deboli (nebulose o galassie). Ma cosa influenza la FWC? Sono numerosi i fattori che entrano in gioco come l’architettura del pixel e la grandezza della regione di svuotamento ma quello principale rimane la superfice dell’elemento fotosensibile o, in breve, il pixel fill factor.

Se le microlenti riescono infatti ad aumentare il pixel fil factor, queste non sono in grado di aumentarne anche la full well capacity che quindi rimane bassa per i sensori CMOS rispetto a quelli CCD. Questa caratteristica si traduce in un sostanziale aumento della dinamica delle camere CCD rispetto alle normali reflex digitali. Questo è uno dei motivi che, ancor oggi, fa prevalere le CCD in ambito astronomico.