Dopo una lunga notte passata al freddo sotto le stelle è giunto il momento di elaborare le nostre immagini astronomiche. Nei post relativi a PixInsight considereremo il caso in cui le immagini astronomiche sono state acquisite con una CCD monocromatica. Se tutto è andato per il verso giusto dovreste quindi avere nel vostro hard disk numerosi light, bias, dark e flat frame relativi a ciascuno dei tre/quattro canali che avete previsto di utilizzare, come ad esempio: Rosso (R), Verde (G), Blu (B), Luminanza (L), H-alpha (Hα), Ossigeno (OIII), Zolfo (SII), Luminanza filtrata (L|UHC, L|CLS, L|UHC-E,…) e molti altri.

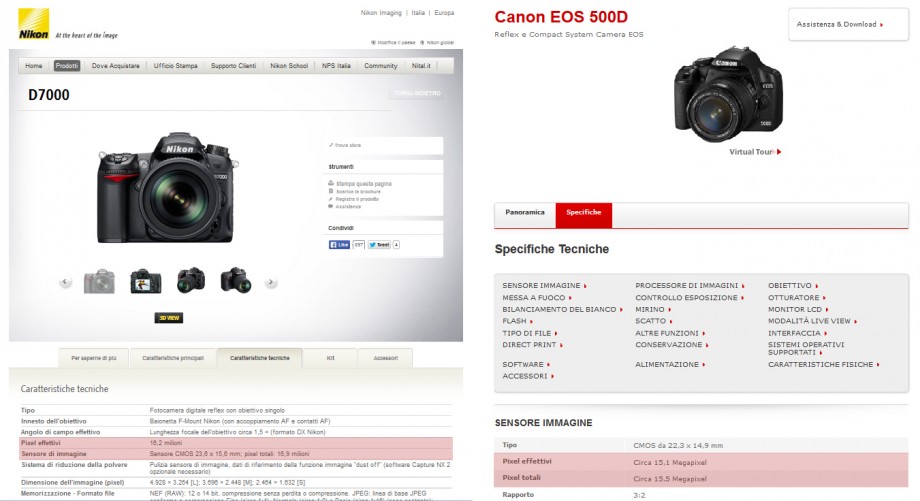

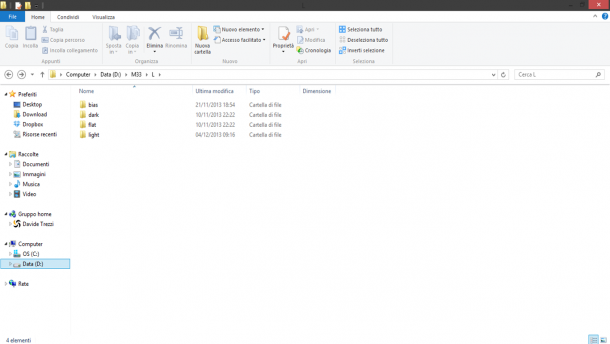

Cominciamo quindi con l’ordinare i frame in cartelle e sottocartelle. In particolare create nella cartella con il nome dell’oggetto (ad esempio “M33”) le sottocartelle di canale che nel caso in esame (composizione LRGB) saranno “L”, “R”, “G” e “B”. In ogni sottocartella di canale create le sottocartelle di calibrazione “bias”, “dark”, “flat” e “light”. Spostate quindi i vostri file nelle relative sottocartelle e fate una copia di backup della cartella principale (vedi Figura 1).

- Figura1: struttura della sottocartella ”L”. La cartella principale è ”M33” e contiene tutte le immagini riprese nella notte.

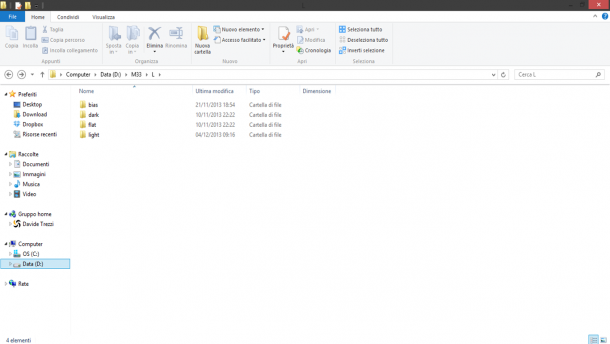

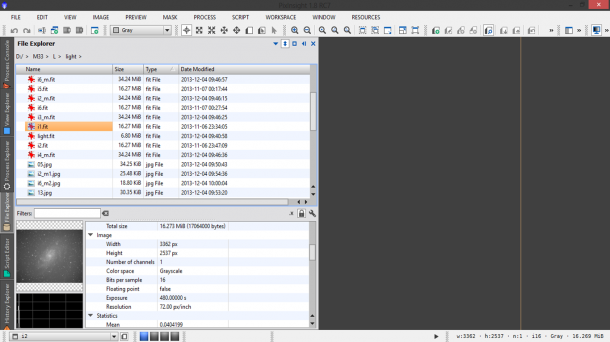

Ora che avete fatto ordine nel vostro PC ed avete messo al sicuro le vostre immagini non vi resta che aprire PixInsight. Il programma aprirà di default la finestra Process Console che vi darà il benvenuto mostrando le caratteristiche del programma e del vostro computer. Siamo quindi pronti per iniziare? Diciamo di si ma dato che non ci fidiamo di noi stessi è sicuramente buona consuetudine verificare che binning e tempo di esposizione siano stati impostati correttamente per ogni categoria di frame (light e di calibrazione). Per fare questo utilizziamo il tab File Explorer e navighiamo nel nostro hard disk sfogliando i vari frame che andremo ad utilizzare. Per ogni frame verranno visualizzati i dati di scatto tra cui appunto Exposure e XBINNING, YBINNING ovvero il tempo di esposizione ed il binning orizzontale e verticale. In Figura 2 ad esempio è mostrato un light frame errato con tempo di esposizione di 480 secondi rispetto agli 800 di tutti gli altri light frame.

- Figura 2: Esempio di light frame errato e che quindi dovrà essere escluso nei processi di calibrazione delle immagini astronomiche.

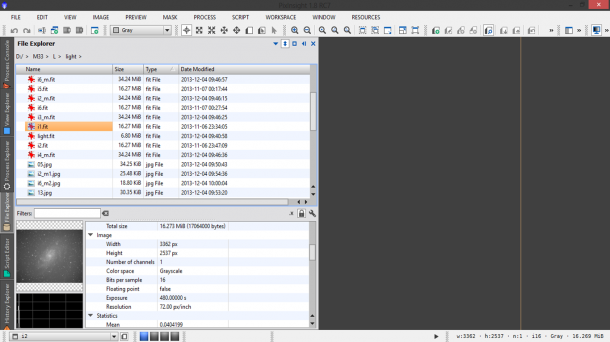

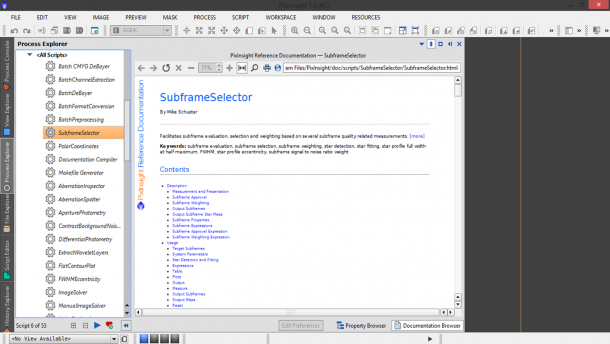

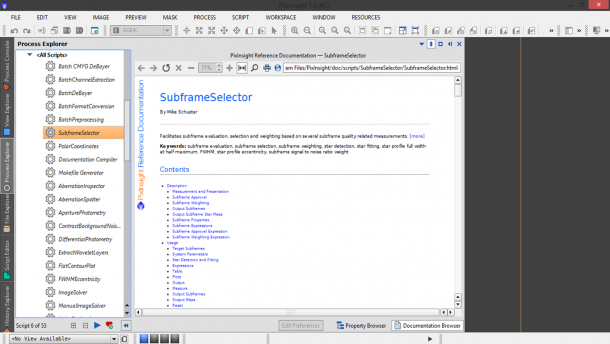

Una volta che siamo sicuri di quali sono i frame corretti, cominciamo a valutarne la qualità. Generalmente i frame di calibrazione (bias, dark e flat) sono tutti di buona qualità nel senso che durante le fasi di realizzazione dei rispettivi master frame esistono metodi per eliminare eventuali imperfezioni (come ad esempio la presenza di raggi cosmici o di fenomeni transienti). Per i light è invece importante studiare i singoli frame per capire se si è ottenuto del mosso o se delle nubi o velature hanno rovinato le nostre immagini. Per fare questo dobbiamo andare a “misurare” i nostri light frame e questo può essere fatto utilizzando lo script SubframeSelector eseguibile cliccando due volte sull’apposita icona nel tab Process Explorer (vedi Figura 3) oppure cliccando sul menù Script → Batch Processing → SubframeSelector.

Figura 3: Lo script SubframeSelector. Cliccando una volta sull'icona è possibile visualizzare la descrizione dello script.

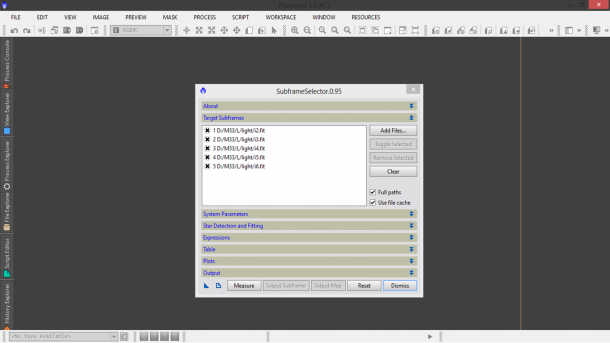

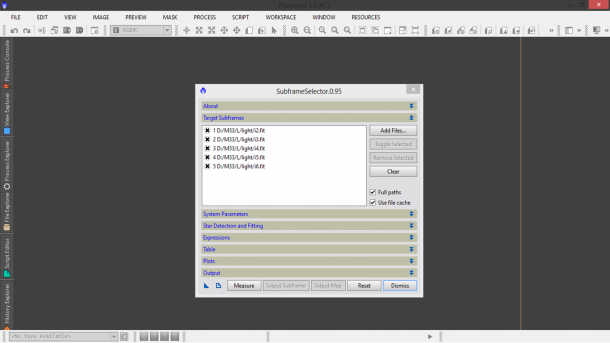

Una volta cliccato sullo script si aprirà una finestra divisa in varie sezioni. La prima, About, fornisce alcune informazioni generali sullo script. Passiamo quindi alla seconda, Target Subframes che ci permette di indicare quali saranno i light frame da analizzare (vedi Figura 4). Nel nostro caso selezioniamo (attraverso il pulsante Add Files…) i light frame relativi al canale di luminanza L. Ovviamente questa operazione andrà effettuata per ciascun canale ripreso (nel nostro caso L, R, G e B). Spuntando Full paths è possibile visualizzare il percorso completo dei files. Consigliamo di spuntare anche Use file cache che permette di mantenere in memoria alcuni dati utili nel caso si voglia analizzare di nuovo le immagini selezionate. Questo permette di minimizzare i tempi di elaborazione di PixInsight.

Figura 4: Lo script SubframeSelector ed in particolare la sezione ''Target Subframes''.

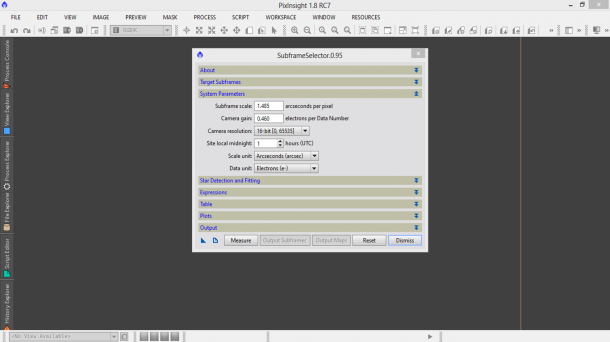

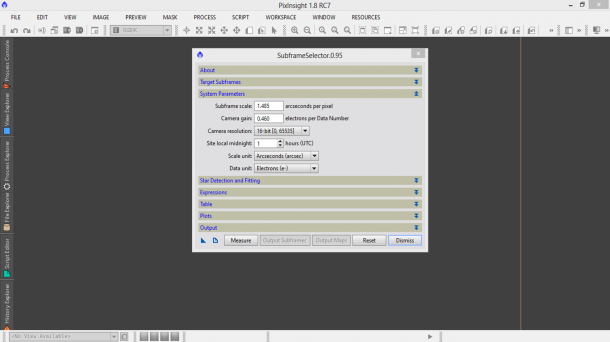

Nella sezione System Parameters dobbiamo inserire i dati relativi alla nostra camera di ripresa, in particolare: il Subframe scale ovvero la scala di ripresa misurata in arcosecondi per pixel (vedi il post “Determinare il fattore di scala”) il Camera gain ovvero il guadagno della nostra CCD (vedi il post “Il guadagno di una camera digitale”) il Camera resolution espresso in bit (questo è riportato nelle specifiche tecniche della camera), il Site local midnight ovvero l’ora della mezzanotte UT misurata nel paese dove è stata ripresa l’immagine. Nel caso dell’Italia è 1, dato che siamo a +1 ora dal meridiano di Greenwich. Scale unit va settata in arcsecondi e Data unit in elettroni. Per la camera ATIK 383L+ monocromatica i valori da settare (binning 1×1) sono riportati in Figura 5.

Figura 5: I settaggi "System Parameters" per una ATIK 383L+ monocromatica in binning 1x1.

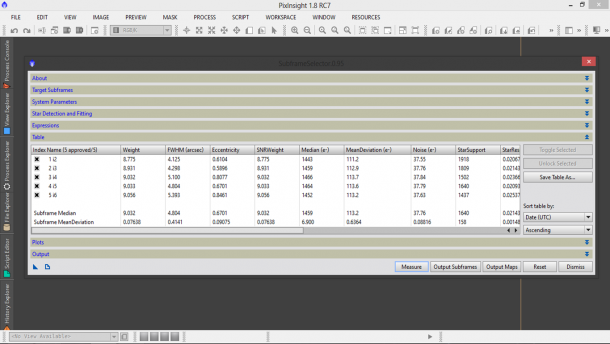

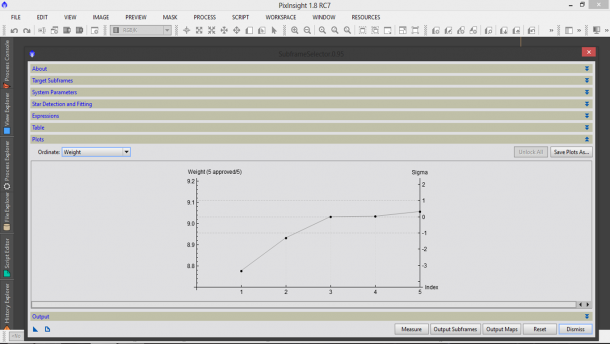

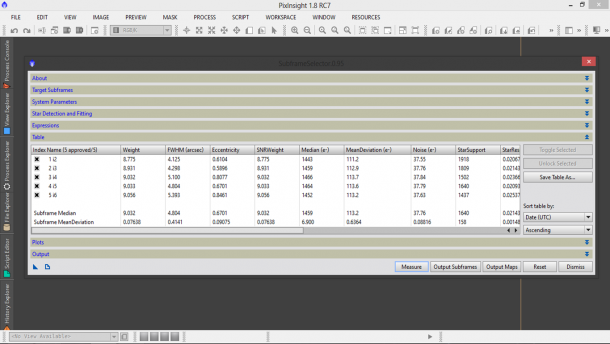

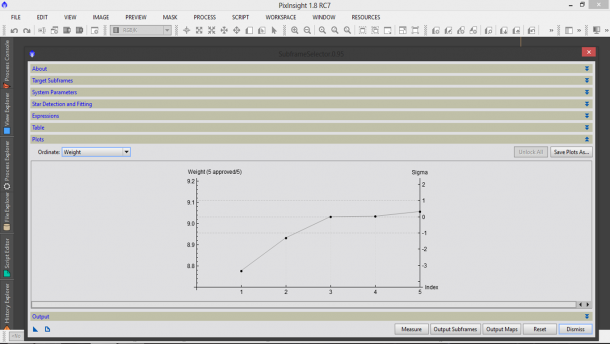

A questo punto lasciamo invariati i settaggi delle categorie Star Detection and Fitting, Expressions e Output e clicchiamo sul tasto Measure. PixInsight comincerà così a misurare le nostre immagini come visibile nella finestra Process Console che si aprirà automaticamente appena cliccato su Measure. I risultati dell’analisi saranno riportati nelle categorie Table e Plots e potranno (dovranno) essere salvati su file cliccando sui tasti “Save Table As…” e “Save Plot As…” (vedi Figure 6 e 7).

Figura 6: La categoria Table dove sono mostrati i risultati numerici dell'analisi.

Figura 7: La categoria Plots dove sono mostrati i grafici relativi all'analisi dei frame.

Per concludere la procedura di calcolo clicchiamo sul pulsante Output Maps ed attendiamo che PixInsight faccia i suoi calcoli. A questo punto possiamo chiudere lo script cliccando su Dismiss e confermandone la chiusura.

Se tutto è andato a buon fine a questo punto nella vostra sottocartella M33/L/light dovreste avere oltre ai light frame anche un file di excel che contiene la tabella con i dati numerici dell’analisi, un file FIT con i grafici associati ed un file FIT per ogni light frame contenente le mappe d’analisi. Vediamo ora quali, di tutte queste informazioni, ci servono per identificare i frame di qualità scarsa ossia da escludere nel processo di calibrazione.

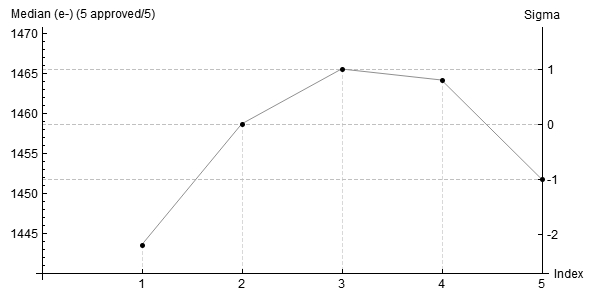

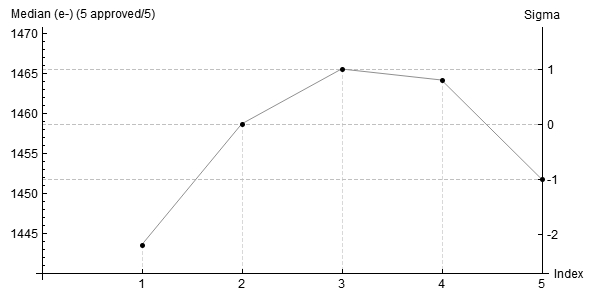

Al fine di identificare il passaggio di nuvole o velature utilizziamo la grandezza fisica Median ovvero la mediana del numero di elettroni accumulati nei pixel del sensore. Se una nuvola o una velatura è passata nel campo di ripresa, questa può o aumentare la luminosità del soggetto nel caso di luoghi inquinati oppure diminuirla nel caso di luoghi bui. Apriamo quindi il grafico relativo al parametro Median utilizzando o la categoria Plots dello script subframeSelector (in questo caso non dovevate chiuderlo) oppure aprendo con PixInsight (File → Open…) il file dei Plot selezionando quello relativo al parametro Median. Nel nostro il risultato dell’analisi è riportato in Figura 8.

Figura 8: la mediana degli elettroni accumulati nei pixel del sensori relativa ai light frame del canale L.

Come si vede dal grafico tutte le immagini hanno mantenuto lo stesso valore di mediana. Piccole variazioni come quelle riportate possono essere dovute ad una variazione di inquinamento luminoso, assorbimento atmosferico o fenomeni di minore importanza.

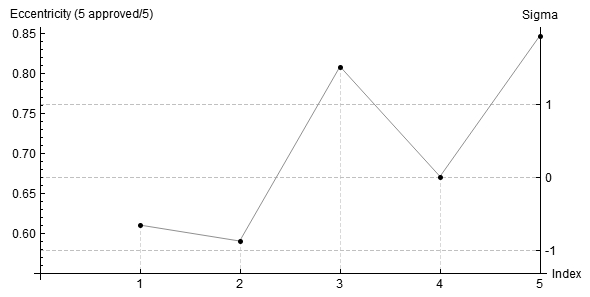

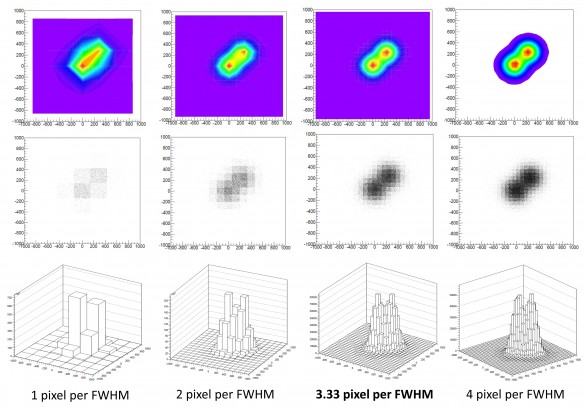

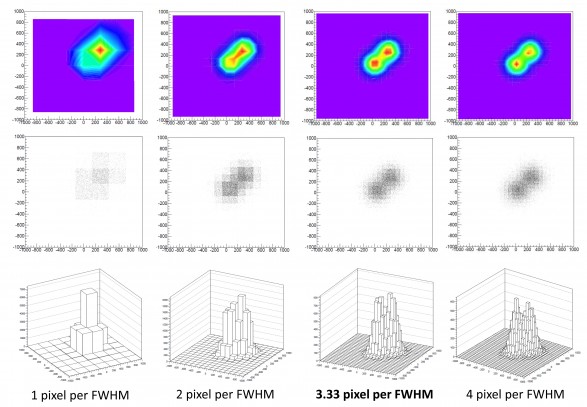

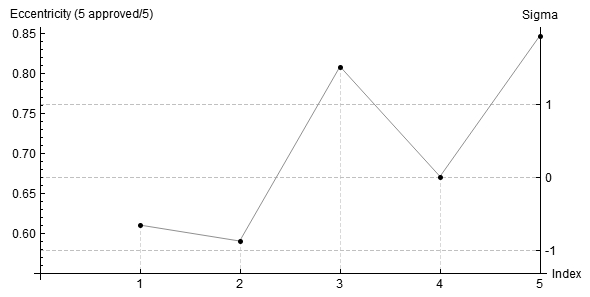

Al fine di identificare invece eventuali problemi di inseguimento utilizziamo la grandezza Eccentricity ovvero la mediana dell’eccentricità delle stelle individuate da PixInsight nel frame. Sia data una stella ellittica e siano a il diametro maggiore e b il minore, l’eccentricità è data dalla radice quadrata di 1-b^2/a^2. Quindi se le stelle sono circolari e quindi a = b abbiamo che l’eccentricità è 0, mentre se la stella è oblunga l’eccentricità è diversa da zero. Stelle con valore di eccentricità inferiore a 0.42 sono ritenute circolari. Il risultato relativo al nostro caso, visualizzabile nella categoria Plots o nel relativo file FIT, è mostrato in figura 9.

- Figura 9: la mediana dell’eccentricità relativa ai light frame del canale L.

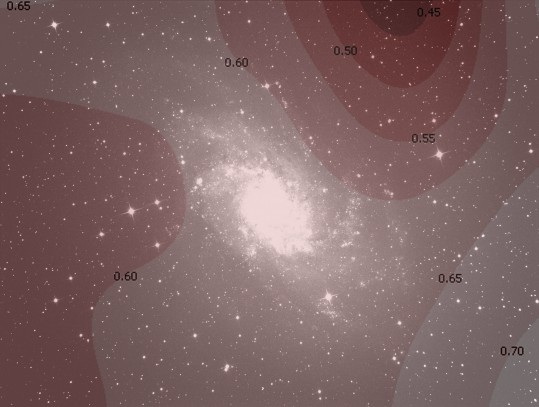

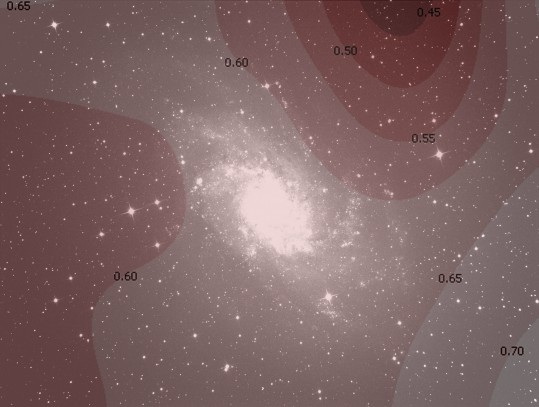

L’immagine mostra che l’eccentricità per i frame 1, 2 e 4 si è mantenuta sempre inferiore a 0.67 mentre per i frame 3 e 5 è superiore a 0.80. Questo significa che questi ultimi presentano del mosso evidente. Un po’ meno mossa è l’immagine 4 mentre la 1 e la 2 hanno eccentricità media (mediana) intorno a 0.60, abbastanza tipica per un telescopio Newton dovuta alla presenza di coma residuo. Per verificare quanto detto possiamo aprire la mappa relativa al frame 2 (sempre cliccando su File → Open…) ed in particolare considerare quella dell’eccentricità. Per comodità l’abbiamo sovrapposta all’immagine stessa (Figura 10). Si noti come il massimo valore di eccentricità è ottenuta in prossimità dell’angolo del campo dove è presente maggior coma residuo.

Figura 10: la mappa di eccentricità sovrapposta al relativo light frame. Per la gran parte del fotogramma l'eccentricità mediana è pari a circa 0.60

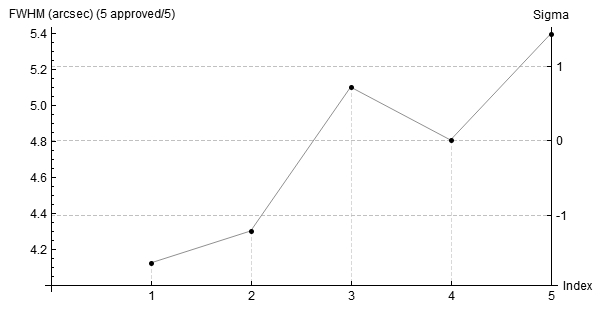

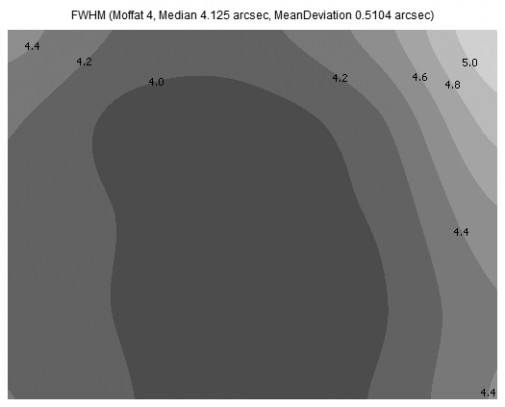

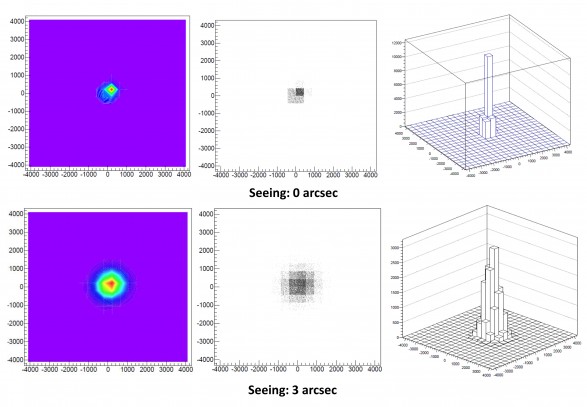

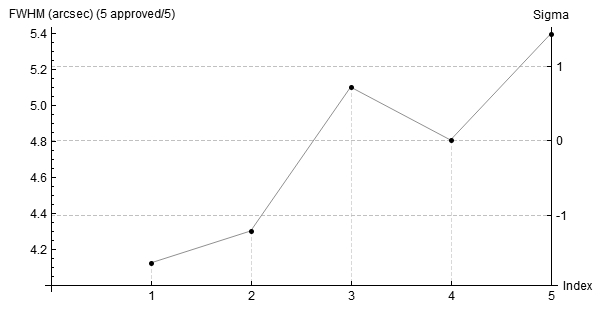

Infine verifichiamo una variazione del fuoco durante il processo di ripresa delle immagini. Per fare questo utilizziamo la quantità fisica FWHM ovvero la mediana dell’ampiezza a metà altezza delle stelle rivelate da PixInsight nel frame considerato. Visualizziamo quindi il grafico FWHM dalla categoria Plots o aprendo il file FIT associato. Il risultato per i frame in esame è riportato in Figura 11.

Figura 11: la mediana della FWHM relativa alle stelle rivelate da PixInsight nei singoli frame.

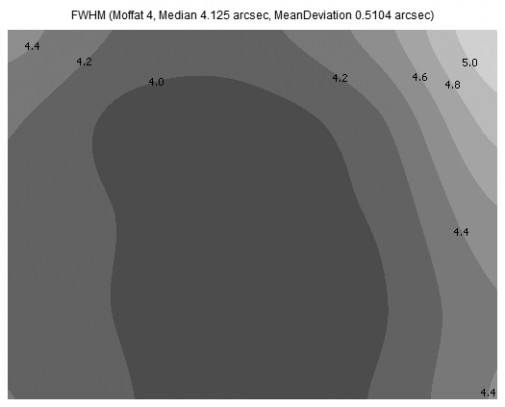

Come si vede dal grafico la FWHM è aumentata nel tempo mantenendosi comunque entro valori accettabili. In questo caso i dati sono inficiati da un continuo e progressivo peggioramento nella qualità dell’inseguimento con aumento dell’eccentricità e quindi della FWHM associata alle stelle. Anche in questo caso si può notare come i frame 3 e 5 siano i peggiori. Piccole variazioni di FWHM sono possibili a seguito di una variazione del seeing. Se osserviamo la mappa associata al frame numero 1 è possibile vedere (Figura 12) come le stelle siano puntiformi in gran parte del campo inquadrato sintomo di una complessiva buona qualità dello strumento ottico.

Figura 12: Mappa della mediana della FWHM relativa al frame 1.

La mappa mostra come la FWHM sia pari a 4.0/4.2 arcsec nella regione centrale del fotogramma, praticamente 4 volte il potere risolutivo teorico del telescopio (l’immagine risulta comunque sottocampionata). Questo mostra come (vedi post “Il potere risolutivo”) la turbolenza atmosferica e la qualità ottica contribuiscono in maniera importante alla risoluzione complessiva del nostro setup astronomico.

Come detto precedentemente, questa procedura preliminare di verifica dei frame deve essere eseguita per ogni canale che vogliamo utilizzare al fine di comporre l’immagine finale. Fatto questo siamo pronti per passare alla fase di “Calibrazione delle immagini astronomiche”.